Я часто сравниваю Google и Microsoft, когда думаю о том, кто сейчас диктует тон в области ИИ. Мне интересно, как две гигантские компании с разными культурами и историями подходят к одной и той же задаче. Я пишу просто и по-человечески, чтобы было легко понять, где у кого преимущество и почему это важно.

- Google и Microsoft

- Ресурсы и инфраструктура

- Центры обработки данных и вычислительная мощность

- Специализированные чипы и аппаратные оптимизации

- Модели и научные достижения

- Архитектуры и ключевые модели

- Научные публикации и вклад в сообщество

- Продукты и коммерциализация

- Облачные сервисы и платформы для ИИ

- Потребительские и корпоративные продукты с ИИ

- Стратегии разработки и распространения

- Политика выпуска и коммерческая закрытость

- Интеграция ИИ в существующие продукты и экосистемы

- Исследования, таланты и экосистема

- Набор талантов и академические партнёрства

- Инвестиции, стартапы и корпоративные альянсы

- Этика, безопасность и регулирование

- Механизмы контроля и тестирования на безопасность

- Работа с регуляторами и общественными организациями

- Конкурентные преимущества и уязвимости

- Сильные стороны Google

- Сильные стороны Microsoft

- Коммерческие показатели и влияние на рынок

- Доходы, инвестиции и бизнес‑модель монетизации ИИ

- Разработчики, инструменты и сообщество

- Фреймворки, API и интеграционные инструменты

- Сопоставление с OpenAI и другими игроками

- Позиционирование против OpenAI и крупных альтернатив

- Стандарты, интероперабельность и переносимость моделей

- Форматы, API и мультиоблачные сценарии

- Риски, этические дилеммы и общественные последствия

- Будущее: сценарии развития и прогнозы

- Краткосрочные прогнозы (1—2 года)

- Долгосрочные перспективы и ключевые факторы успеха

- Вывод: кто выигрывает гонку и по каким критериям

Google и Microsoft

Я вижу Google как компанию, которая выросла из поиска и данных.

Их мозг — это масштабные данные и сервисы, которые уже давно обрабатывают запросы миллиарда пользователей. Microsoft я воспринимаю как мастера интеграции. У них огромная корпоративная база, офисный софт и платформа Azure. Эти две компании играют по разным правилам. Google делает ставку на исследования и собственные стеки технологий.

Microsoft комбинирует собственные разработки с партнерствами и мощной коммерческой силой. Оба вкладывают гигантские ресурсы в дата-центры, чипы и модели. Оба строят экосистемы, но цели разные. Google стремится к прорывам в моделях и продуктах для конечного пользователя.

Microsoft — к массовому внедрению ИИ в бизнес-процессы. Я считаю, что сравнение полезно, потому что оно показывает, как разные пути ведут к похожим результатам: быстрым инновациям и коммерческим решениям.

Ресурсы и инфраструктура

Здесь всё просто: деньги и оборудование решают многое. Компании с большими инвестициями могут тренировать большие модели быстрее. Но важнее не только размер финансирования. Важно, как эти ресурсы организованы. Я смотрю на зоны развертывания, сети, энергопотребление и устойчивость. Google и Microsoft вкладываются в эти области по-своему. Ниже я собрал краткое сравнение и перечисление ключевых элементов инфраструктуры, которые имеют значение при разработке и запуске ИИ.

| Параметр | Microsoft | |

|---|---|---|

| Региональные зоны | Много зон по всему миру, собственные пояса для данных | Широкое покрытие Azure, сильная интеграция с корпоративными сетями |

| Сетевая инфраструктура | Собственная глобальная сеть и оптические линии | Партнёрства и сильные корпоративные каналы |

| Энергоэффективность | Акцент на устойчивое охлаждение и возобновляемую энергию | Инвестиции в энергоменеджмент и устойчивость площадок |

Центры обработки данных и вычислительная мощность

Я часто представляю дата-центры как сердце ИИ-инфраструктуры. В них находятся серверы, вентиляция, системы питания и сети. Google известен своими целыми районами дата-центров с уникальными решениями по охлаждению. Они оптимизируют на уровне помещения и железа. Microsoft делает упор на гибкость Azure. Их дата-центры рассчитаны на разные сценарии: от массовых облачных сервисов до специализированных кластеров для ИИ.

Масштаб вычислений — это не только количество GPU. Это ещё и баланс между CPU, сетью и хранением данных. Медленная сеть может убить даже самый мощный кластер. Я замечаю, что обе компании строят свою инфраструктуру так, чтобы минимизировать задержки и повысить пропускную способность при обучении моделей в сотни миллиардов параметров.

Наличие вычислительных мощностей — не гарантия успеха. Важно, как эти мощности используются и какие решения вокруг них строят.

Вот ключевые элементы, на которые я обращаю внимание при оценке дата-центров:

- Сеть с низкой задержкой между узлами для распределённого обучения.

- Системы хранения с высокой пропускной способностью для датасетов.

- Энергоэффективные охлаждающие технологии и резервирование питания.

- Оркестрация кластеров и управление ресурсами в реальном времени.

Специализированные чипы и аппаратные оптимизации

Чипы делают ИИ быстрее и дешевле. Google разработал TPU. Они оптимизированы для матричных операций. Это даёт преимущество при обучении больших моделей. Microsoft больше работает с партнёрами. Они активно используют NVIDIA GPU и FPGA в рамках своих программ. Я вижу у Microsoft гибридный подход: общего назначения GPU плюс ускорители для специальных задач.

Аппаратные оптимизации — это не только чипы. Это компиляторы, планировщики задач и библиотеки. Google развивает XLA и собственные оптимизации для TPUs. Microsoft поддерживает CUDA, ONNX и оптимизации для Azure. В результате, один и тот же модельный код может работать по-разному и показывать разную экономику обучения в зависимости от стека.

- TPU (Google) — эффективность при крупных матричных вычислениях.

- GPU (NVIDIA) — универсальность и зрелая экосистема.

- FPGA и кастомные ASIC — низкая латентность для специфичных задач.

- Софт-оптимизации (компиляторы, бэкенды) — критичны для реальной производительности.

Модели и научные достижения

Я слежу за тем, как быстро развиваются модели у Google и Microsoft. Обе компании сделали огромный шаг от базовых трансформеров к мощным мультизационным системам. Тут важно понимать не только громкие названия, но и принципы: масштабирование, оптимизация обучения, маршруты к мультимодальности и интеграция поиска с генерацией. Я заметил, что у каждой компании есть своя сильная ниша. Google часто фокусируется на фундаментальной архитектуре и масштабных исследованиях. Microsoft больше работает на инженерные оптимизации и внедрение в продукты. В сумме это выглядит как соревнование и сотрудничество одновременно. Для практического применения это значит: модели становятся быстрее, умнее и доступнее через облака и API.

Архитектуры и ключевые модели

Я люблю разбирать архитектуры по частям. Начнём с трансформера — он стал базой для всего. Google создал Transformer, потом пришли BERT и T5. Эти модели задали направление на представление и генерацию текста. Позже появились большие универсальные модели, такие как PaLM и Gemini. Они объединяют масштабирование и мультимодальность.

Microsoft сделал упор на инженерные решения. Turing-серия показала навыки генерации. DeepSpeed и ZeRO позволили учить огромные модели эффективнее. Microsoft активно сотрудничает с партнёрами и интегрирует крупные языковые модели через Azure и OpenAI.

Тренды, которые я вижу сейчас:

- Масштабирование по параметрам и данным.

- Sparse-архитектуры и mixture-of-experts для экономии ресурсов.

- Retrieval-augmented generation — встроенный поиск для точности фактов.

- Мультимодальные блоки, которые объединяют текст, картинку и звук.

| Компания | Модель | Ключевая особенность |

|---|---|---|

| BERT, T5, PaLM, Gemini | Фундаментальные архитектуры и мультимодальность | |

| Microsoft | Turing, DeBERTa, решения DeepSpeed | Инженерная оптимизация и масштабирование в облаке |

| Совместно/партнёры | Azure + OpenAI | Доступ к крупным GPT-моделям и интеграция в сервисы |

Мне кажется, архитектурные идеи уже перешли в стадию практического использования — теперь важны скорость, стоимость и надёжность.

Научные публикации и вклад в сообщество

Я ценю, когда компании делятся знаниями. Google регулярно публикует работы и открывает код. Так появляются BERT, T5 и исследования по масштабированию. Microsoft тоже публикует и выкладывает инструменты — DeepSpeed, DeBERTa и оптимизации для обучения. Это помогает академии и индустрии двигаться быстрее.

Что я особенно отмечаю:

- Открытый код для обучения и инференса.

- Релизы моделей и чекпойнтов в исследовательских целях.

- Публикации по оптимизациям памяти и распределённому обучению.

- Работа над бенчмарками и репликацией экспериментов.

Такая открытость ускоряет творчество и улучшает воспроизводимость. Я часто беру идеи из этих публикаций и применяю их в проектах.

Продукты и коммерциализация

Здесь я смотрю на то, как исследования превращаются в продукты. Google предлагает Vertex AI, API PaLM и чат-ассистентов, таких как Bard и Gemini. Это доступ к моделям через облако и удобный интерфейс для бизнеса. Microsoft продаёт ИИ через Azure OpenAI Service и интегрирует модели в продукты: GitHub Copilot, Microsoft 365 Copilot, Bing Chat. Для меня важно, как легко подключить модель к реальному рабочему процессу.

Ключевые направления монетизации и внедрения:

- Облачные API по подписке и с платой за использование.

- Готовые решения для бизнеса и кастомизация моделей под клиента.

- Интеграция в офисные приложения и инструменты разработчика.

- Гибридные и приватные развертывания для крупных компаний.

| Компания | Продукт | Фокус коммерциализации |

|---|---|---|

| Vertex AI, Bard, Gemini API | Облачные модели и платформы для данных | |

| Microsoft | Azure OpenAI, Copilot, Microsoft 365 Copilot | Интеграция в корпоративные рабочие процессы |

Мне кажется, победит тот, кто сделает ИИ максимально полезным и простым в повседневной работе компании.

Облачные сервисы и платформы для ИИ

Я часто говорю, что без инфраструктуры все крутые модели — это просто эксперименты. Обе компании строят мощные облачные платформы для реальных задач. Google делает ставку на интеграцию данных и аналитики. У них удобные инструменты для обучения и развёртывания моделей в масштабе. Microsoft фокусируется на готовых энтерпрайз‑решениях и глубокой интеграции с Office и Azure‑экосистемой. Обе стороны предлагают AutoML, управляемые сервисы для ML‑pipelines и инструменты для мониторинга моделей в проде.

| Облако | Основные сервисы | Ключевые фишки | Модель тарификации |

|---|---|---|---|

| Google Cloud | Vertex AI, BigQuery ML, TPU | Интеграция с аналитикой, управление данными | Почасово за обучение и инференс, отдельные квоты |

| Microsoft Azure | Azure ML, Cognitive Services, Synapse | Интеграция с 365, корпоративные SLA | Пакеты для предприятий, платёж за использование |

Типичные сценарии применения легко перечислить. Я вижу их так:

- Обработка больших данных и обучение моделей на собранных багах данных.

- Развёртывание кастомных моделей рядом с данными для низкой задержки.

- Использование предобученных сервисов для распознавания речи, картинок и текста.

В реальных проектах ключ не только в модели, а в том, как она работает с данными и как её можно масштабировать.

Потребительские и корпоративные продукты с ИИ

Я люблю смотреть на ИИ через призму продуктов. С одной стороны, есть функции для обычных пользователей: автозаполнение, умные подсказки в почте и редакторах, голосовые ассистенты. С другой стороны, корпоративные продукты превращают эти функции в бизнес‑ценность. Тут важны безопасность, контроль доступа и соответствие регламентам.

- Потребительские фишки: быстрые ответы, персонализация, улучшение фото и голоса.

- Корпоративные решения: автоматизация рабочих процессов, аналитика, помощники для сотрудников.

Для меня очевидно: коммерциализация идёт через два пути. Первый — встроить ИИ в массовые продукты и монетизировать через подписку. Второй — продавать готовые инструменты и кастомные решения компаниям с высокими SLA. Оба пути работают, но они требуют разного подхода к дизайну, поддержке и лицензированию.

Продуктовый ИИ — это не только модель. Это интерфейс, безопасность и процесс внедрения в компании.

Стратегии разработки и распространения

Я слежу за стратегиями обеих компаний и вижу четкие различия. Google часто делает акцент на исследованиях, открытых проектах и интеграции ИИ в массовые сервисы. Microsoft идёт по пути глубокой интеграции с бизнес‑продуктами и партнёрскими экосистемами. Оба используют партнёров, маркетплейсы и программы сертификации, но с разной тактикой монетизации.

Основные каналы распространения, которые я использую в проектах:

- Прямые продажи крупным клиентам через корпоративные команды.

- Маркетплейсы облачных провайдеров для ISV и интеграторов.

- Партнёрские программы и системные интеграторы для локальных внедрений.

Технологически важная часть стратегии — это разработка SDK, API и готовых коннекторов. Я обычно строю продукт так, чтобы его можно было быстро интегрировать в существующие процессы компании. Это ускоряет распространение и снижает порог входа для клиентов.

Политика выпуска и коммерческая закрытость

Я видел разные подходы к выпуску новых возможностей. Один вариант — быстрый публичный релиз и сбор обратной связи от большого числа пользователей. Другой — поэтапный запуск: сначала внутренне, затем закрытые бета‑тесты и только после этого общедоступный релиз. Компании комбинируют эти подходы в зависимости от риска и регуляторных требований.

Коммерческая закрытость проявляется в нескольких аспектах. Это ограниченный доступ к лучшим моделям, специальные лицензии для предприятий и платные интеграции. Закрытость даёт контроль и доход. Но она усложняет воспроизводимость и сотрудничество с сообществом.

Я выделяю типичные этапы выпуска:

- Внутреннее тестирование и proof‑of‑concept.

- Ограниченная бета с ключевыми клиентами.

- Расширенная бета с платными пилотами.

- Общий релиз с коммерческими планами и поддержкой.

В заключение скажу так: закрытость помогает защитить коммерческую ценность. Открытость ускоряет принятие и доверие. Я предпочитаю гибридный подход: открывать инструменты для разработчиков и оставлять критичные модели под коммерческими соглашениями. Это даёт баланс между инновациями и устойчивым бизнесом.

Интеграция ИИ в существующие продукты и экосистемы

Я вижу интеграцию ИИ как не про «внедрить модель и всё решено». Это про плавные изменения в опыте пользователей. Сначала добавляют невидимые улучшения — поиск, рекомендации, автоматическое исправление. Потом приходят видимые функции — помощники, автогенерация контента, аналитика в реальном времени. Тут важна последовательность. Маленькие выигрыши укрепляют доверие. Резкие вмешательства пугают людей и бизнес-процессы.

Интеграция эффективна, когда помощь заметна, но не навязчива.

Я обращаю внимание на два технических подхода. Первый — API-first: сервисы открывают интерфейсы, и экосистема строит над ними плагины и приложения. Второй — глубокая встроенность: ИИ становится частью платформы, где он оптимизирован под конкретные сценарии. Оба подхода работают. Выбор зависит от целей и масштаба.

| Аспект | Microsoft | |

|---|---|---|

| Глубина интеграции | Поиск, Workspace, Android | Office, Windows, Teams |

| Фокус | пользовательский опыт и масштабирование | корпоративные рабочие процессы и совместная работа |

| Платформенные инструменты | облачные API и ML-инструменты | сервисы Azure и интеграция в продукты |

Если вам нужно внедрять ИИ в свой продукт, я рекомендую такой план:

- Определить конкретную проблему, а не «хочу ИИ».

- Прототипнуть легкое решение и измерить эффект.

- Тестировать с живыми пользователями и собирать обратную связь.

- Постепенно расширять функционал и следить за безопасностью.

Исследования, таланты и экосистема

Развитие ИИ — это не только модели и серверы. Это люди, идеи и связи между ними. Компании вкладывают ресурсы в лаборатории, стипендии и совместные проекты с университетами. Я вижу это как капитальную ставку на долгую перспективу. Без сильной исследовательской базы трудно поддерживать лидерство.

Набор талантов и академические партнёрства

Найм специалистов по ИИ сегодня похож на гонку за редкими кадрами. Я замечаю три ключевых подхода: конкурсы и хакатоны, стипендии и совместные программы, открытые стажировки. Университеты дают свежие идеи. Компании дают реальный масштаб для экспериментов. Взаимодействие работает, когда есть четкие исследовательские задачи и доступ к данным.

- Что привлекает талантов: интересные задачи, свобода исследований, доступ к данным и вычислениям, конкурентная компенсация.

- Что дает партнёрство: публикации, совместные курсы, обмен кадрами, реальный кейс для студентов.

Я считаю важным поддерживать открытые инициативы. Они дают канал притока новых специалистов и помогают формировать стандарты.

Инвестиции, стартапы и корпоративные альянсы

Инвестиции и альянсы формируют экосистему вокруг крупных игроков. Я часто вижу стратегию «покупай, инвестируй, партнёрствуй». Это сокращает время на выход новых решений и расширяет портфель технологий. Стартапы получают ресурсы и рынок. Корпорации — инновации и гибкость.

- Формы сотрудничества: венчурные фонды, совместные лаборатории, покупка стартапов, интеграционные партнёрства.

- Плюсы для экосистемы: быстрый доступ к новым идеям, обмен талантами, коммерческая реализация технологий.

Я рекомендую уделять внимание не только крупным инвестициям. Малые гранты и акселераторы часто приносят прорывные идеи. Сбалансированный портфель альянсов делает экосистему устойчивой и адаптивной.

Этика, безопасность и регулирование

Я считаю, что этика и безопасность — не просто слова в пресс-релизах. Это те вещи, которые влияют на продукт у людей в кармане и на доверие к компаниям. Когда говорю об этом, я имею в виду реальные механизмы контроля, тесты и взаимодействие с регуляторами. Ниже я подробно разбираю, как это выглядит на практике и какие шаги важны для минимизации рисков.

Механизмы контроля и тестирования на безопасность

Я слежу за тем, чтобы тестирование было многослойным. Нельзя полагаться на один инструмент. Нужна комбинация автоматических проверок, человеческого аудита и стресс‑тестов. Вот простая таблица, которая показывает основные типы контрольных мер и их назначение.

| Механизм | Что проверяет | Частота |

|---|---|---|

| Автоматические тесты | Стабильность, регрессии, безопасность API | Ежедневно |

| Ред‑тиминг (red teaming) | Уязвимости, атакующие сценарии | Периодически |

| Человеческий аудит | Этичность ответов, предвзятость | Регулярно |

| Фильтры контента | Неприемлемое поведение, токсичность | В реальном времени |

Кроме таблицы, есть список практик, которые я считаю обязательными:

- Дерегистрация и анализ инцидентов.

- Тестирование на краевые и редкие сценарии.

- Метрики устойчивости и объяснимости моделей.

- Использование симуляций для оценки поведения в необычных условиях.

Безопасность — это не цель, а процесс. Я всегда это повторяю команде.

Работа с регуляторами и общественными организациями

Я стараюсь держать связь с внешними организациями. Регуляторы задают рамки. Общественные группы выносят реальные проблемы. Вместе это помогает делать технологии безопаснее.

Моя практика обычно включает такие шаги:

- Прозрачность: публикую отчёты и описания рисков.

- Консультации: обсуждаю решения с независимыми экспертами.

- Пилоты: запускаю ограниченные тесты перед масштабом.

- Обратная связь: собираю мнения пользователей и НКО.

Иногда я инициирую открытые дискуссии и воркшопы. Это помогает выровнять ожидания общества и бизнеса. Важно не прятаться за формулировками. Лучше показывать, что тесты и исправления идут постоянно.

Конкурентные преимущества и уязвимости

Я вижу конкуренцию как комбинацию сильных сторон и зон риска. У каждой компании есть преимущества. Есть и уязвимости. Разбор таких элементов помогает понять, кто лидирует по конкретным критериям.

Сильные стороны Google

Я считаю, что Google обладает несколькими реальными преимуществами. Они видны не только в продуктах, но и в инфраструктуре. Вот что я считаю ключевым.

- Данные. Google имеет огромные массивы пользовательских и телеметрических данных. Это даёт преимущество в обучении и тонкой настройке моделей.

- Поиск и понимание языка. Поисковые технологии и экспертиза в NLP у Google на очень высоком уровне.

- Инфраструктура. Собственные дата‑центры и сети обеспечивают скорость и масштабируемость.

- Экосистема сервисов. Интеграция с почтой, картами, офисными инструментами ускоряет внедрение ИИ.

Я также замечаю сильный научный бэкграунд. Google активно публикует исследования и участвует в развитии открытых стандартов. Это привлекает таланты и даёт технологические преимущества.

| Область | Преимущество Google |

|---|---|

| Данные | Широкий доступ и разнообразие |

| Поиск | Лидерство в ранжировании и семантике |

| Инфраструктура | Высокая пропускная способность и глобальная сеть |

Эти сильные стороны не делают Google непобедимым. Но они дают серьёзный буст в разработке и выводе продуктов на рынок.

Сильные стороны Microsoft

Я вижу Microsoft как компанию, которая выигрывает благодаря сочетанию облачной мощности и глубокой интеграции в корпоративные процессы. Azure даёт масштаб и гибкость для больших рабочих нагрузок. Windows, Office и Microsoft 365 остаются в центре бизнеса. Это упрощает внедрение ИИ прямо в привычные инструменты. GitHub и LinkedIn дают доступ к разработчикам и кадрам. Мощная коммерческая сеть и долгие отношения с крупными клиентами ускоряют продажи новых решений. Microsoft умеет продавать комплексные пакеты: софт, облако, сервисы и поддержку. Корпоративная культура безопасности и соответствия требованиям привлекает регуляторов и клиентов. Инвестиции в OpenAI и приобретение профильных компаний усиливают позицию. В результате у Microsoft есть и технологии, и каналы, и доверие рынка. Это комбинация, которую сложно быстро повторить.

Коммерческие показатели и влияние на рынок

Я слежу за тем, как ИИ меняет финансовую картину Microsoft. Основные доходы идут через облако и подписки на продуктивность. Появились новые источники — платный доступ к ИИ‑функциям и консалтинг. Это меняет модель монетизации: от лицензий к подпискам и оплате за потребление. Влияние на рынок заметно. Поставщики ПО и системные интеграторы подстраиваются под Azure. Клиенты ожидают встроенного ИИ в привычных сервисах.

| Сегмент | Роль в ИИ‑монетизации |

|---|---|

| Azure | Инфраструктура для обучения и хостинга моделей, оплата по использованию |

| Microsoft 365 / Copilot | Подписки с добавленной стоимостью через ИИ‑функции |

| GitHub / LinkedIn | Инструменты и данные для разработчиков, monetизация через сервисы и обучение |

Доходы, инвестиции и бизнес‑модель монетизации ИИ

Я понимаю доходы Microsoft через призму разных каналов. Основной — облако. Azure приносит оплату за вычисления, хранение и управляемые сервисы. Второй — подписки. Microsoft 365 с Copilot увеличивает среднюю выручку на пользователя. Третий — лицензирование и корпоративные контракты. Четвёртый — прямые API и платные интеграции, например Azure OpenAI. Ещё есть консалтинг и managed services. Компания инвестирует в OpenAI, покупает профильные активы и тратит много на R&D. Это важно. Инвестиции дают доступ к передовым моделям и ускоряют внедрение.

- Модели монетизации: подписка, оплата за потребление, лицензирование, премиум‑функции.

- Инвестиционные направления: партнерства, приобретения, внутренние исследования, инфраструктура.

- Риски: ценовая конкуренция, необходимость масштабирования инфраструктуры, регуляторное давление.

Для меня очевидно: ИИ превращается в продукт, который нужно уметь продавать и поддерживать, а не только создавать.

Разработчики, инструменты и сообщество

Я часто работаю с экосистемой Microsoft. Там есть инструменты для каждой стадии — от эксперимента до промышленного запуска. Azure ML и Cognitive Services покрывают типовые сценарии. GitHub и GitHub Copilot помогают писать код быстрее. Visual Studio и VS Code делают разработку удобной. SDK и API позволяют интегрировать модели в приложения и рабочие процессы. Документация и обучающие курсы помогают войти в экосистему. Партнёрская сеть и сертификация облегчают поиск подрядчиков.

- Основные инструменты: Azure ML, Cognitive Services, Bot Framework, GitHub, Visual Studio.

- Поддержка: SDK, CLI, примеры, шаблоны развертывания.

- Сообщество: открытые репозитории, конференции, партнерские программы.

Разработчики ценят, когда можно быстро прототипировать и сразу масштабировать в облаке.

Фреймворки, API и интеграционные инструменты

Я всегда смотрю на стек с практической стороны. Выбор фреймворка влияет на скорость разработки и развёртывания. TensorFlow и PyTorch — самые очевидные. TensorFlow хорош для промышленного продакшна и TFX-пайплайнов. PyTorch удобен для экспериментов и быстро внедряется в прод. JAX выбирают для численной скорости и кастомных оптимизаций.

Для интеграции важно понимать, как модель попадёт в сервис. Часто использую следующие инструменты:

- ONNX — мост между фреймворками.

- TFX / Kubeflow — для конвейеров и CI/CD моделей.

- Docker + Kubernetes — для упаковки и масштабирования.

- Cloud SDK (Azure, Google Cloud) — для деплоя и мониторинга.

| Название | Языки/интерфейс | Ключевая особенность |

|---|---|---|

| PyTorch | Python | Быстрые эксперименты, динамический граф |

| TensorFlow | Python, C++ | Масштабирование, TFX для продакшна |

| ONNX | Модельный формат | Переносимость между фреймворками |

Я считаю: правильно выбранный инструмент экономит недели работы, а не только часы.

Сопоставление с OpenAI и другими игроками

Здесь я смотрю не на маркетинг, а на практику. OpenAI сделал API простым и мощным. Microsoft даёт инфраструктуру и интеграции в корпоративные продукты. Google предлагает экосистему облака и инструменты для ML-жизненного цикла. Anthropic делает акцент на безопасности. Meta и другие игроки фокусируются на открытых моделях и масштабируемости.

Ключевые отличия в паре слов:

- OpenAI — удобство API и качество моделей.

- Microsoft — корпоративный фокус и масштаб Azure.

- Google — платформа, инструменты данных и исследования.

- Anthropic/Meta — безопасность и открытость соответственно.

Для бизнеса вопрос часто не «кто сильнее», а «какая комбинация инструментов решит мою задачу».

Позиционирование против OpenAI и крупных альтернатив

Если честно, конкуренция — это экосистема. Microsoft выгодно тем, что предлагает Azure OpenAI Service внутри облака. Это упрощает аутентификацию, безопасность и биллинг. Google ставит на Vertex AI и интеграцию с BigQuery. OpenAI остаётся ориентиром по качеству языковых моделей и простоте вызова через API.

Я бы выделил несколько практических моментов при выборе:

- Интеграция с корпоративной инфраструктурой. Microsoft выигрывает в больших компаниях.

- Готовность к кастомизации. Google и open-source-проекты дают больше контроля.

- Соображения по безопасности и соответствию. Anthropic и крупные облака предлагают дополнительные гарантии.

- Стоимость и масштабируемость. Сравнивайте не только цену за запрос, но и стоимость хранения и трансфера данных.

Стандарты, интероперабельность и переносимость моделей

Я всегда на стороне переносимости. Без неё вы привязаны к одному провайдеру. ONNX, SavedModel и TorchScript — базовые форматы. Они позволяют переносить модели между фреймворками и средами исполнения. Для мобайл и edge существуют TFLite и Torch Mobile.

Практическая стратегия, которую я применяю:

- Разрабатывать модель в удобном фреймворке.

- Экспортировать в нейтральный формат (ONNX/SavedModel).

- Тестировать поведение на целевой платформе.

- Версионировать артефакты в репозитории моделей (MLflow, Model Registry).

Используйте контейнеры и инфраструктуру как код. Это убирает сюрпризы при переносе между облаками. В конце концов, стандарты и дисциплина в пайплайне делают проекты живучими и предсказуемыми.

Форматы, API и мультиоблачные сценарии

Я часто встречаю вопросы о том, как переносить модели между облаками и средами. Это реально больная тема для многих команд. Форматы моделей и интерфейсы API решают часть проблем, но не все. В практике используются ONNX, SavedModel для TensorFlow, TorchScript для PyTorch. Каждый формат имеет свои плюсы и ограничения. Переносимость зависит от окружения, зависимостей и оптимизаций под железо.

| Формат | Краткое описание | Кому удобно |

|---|---|---|

| ONNX | Нейтральный формат для обмена между фреймворками | Для мультифреймворковых пайплайнов |

| SavedModel | Стандарт TensorFlow для деплоя и оптимизаций | Если вы в экосистеме Google/TF |

| TorchScript | Формат для производительного исполнения PyTorch-моделей | Для продакшна на PyTorch |

API тоже бывают разные. REST удобен и прост. gRPC быстрее и лучше для стриминга. Вендоры предлагают свои API с дополнительными серверами авторизации, квотами и инструментами мониторинга. Это значит, что миграция между облаками часто упирается не в модель, а в интеграцию сервиса, аутентификацию и биллинг.

- Лучшие практики: стандартизуйте формат, держите контейнеры с зависимостями, автоматизируйте тесты на целевых инстансах.

- Учтите задержки: для интерактивных приложений мультиоблачная маршрутизация может добавлять десятки миллисекунд.

- Безопасность и соответствие: данные часто остаются «привязанными» к одному облаку из‑за регуляций.

Переносимость — это не только совместимость формата. Это управление данными, сетью и операциями.

Риски, этические дилеммы и общественные последствия

Я не люблю пугать, но риски реальны. Модели учат на данных, где есть предвзятость. Они могут усиливать стереотипы. Автоматизация меняет рынок труда. Это создаёт социальные вызовы. Дезинформация и дипфейки становятся доступнее. Приватность данных постоянно под угрозой. Вариант «двойного использования» тоже на виду: те же технологии помогают и медицине, и вредоносным сценариям.

- Биас и справедливость: модели требуют аудита и разнородных датасетов.

- Прозрачность: пользователи должны понимать, как принимаются решения.

- Ответственность: кто отвечает за ошибку ИИ в продукте?

- Регулирование: компании вынуждены адаптироваться под новые законы.

Я считаю, что практические шаги важнее красивых деклараций. Нужно тестировать модели на реальных сценариях. Внедрять мониторинг и процессы отката. Вовлекать внешних экспертов и сообщества. Это уменьшит риски и повысит доверие.

Этика без конкретных процедур остаётся декларацией. Процедуры без этики — риск.

Будущее: сценарии развития и прогнозы

Мне кажется, будущее будет сочетанием нескольких сценариев. Нельзя поставить на одну карту. Развитие пойдёт по разным направлениям в зависимости от политики, экономики и технологий. Я вижу несколько понятных дорожек.

- Централизация: несколько крупных игроков держат ключевые модели и инфраструктуру.

- Децентрализация: открытые модели и сообщество создают альтернативы.

- Регуляторная сдержанность: жесткие правила замедлят некоторые инновации.

- Те, кто оптимизирует под конкретные отрасли, добьются реальной ценности.

Главный фактор успеха — умение сочетать технологию с операциями и доверием. Тот, кто победит, сможет быстро и безопасно доставлять ценность пользователям.

Краткосрочные прогнозы (1—2 года)

В ближайшие один‑два года я ожидаю конкретных и предсказуемых изменений. Интеграция ИИ в продукты ускорится. Больше сервисов получат возможности LLM и мультимодальности. Облако останется главным местом для тяжёлых моделей. При этом появится больше гибридных сценариев: часть вычислений в облаке, часть — на границе сети.

- Повсеместная интеграция: чат‑ассистенты и генерация контента в привычных приложениях.

- Мультимодальные фичи: текст + изображение + звук станут стандартом в новых функциях.

- Появление специализированного железа в дата‑центрах и на edge.

- Регуляторы начнут вводить практические требования к прозрачности и тестированию.

- Консолидация рынка: больше M&A, особенно в нишевых стартапах с уникальными данными или технологиями.

| Явление | Вероятность | Влияние |

|---|---|---|

| Широкая продуктовая интеграция ИИ | Высокая | Сильное |

| Строгое регулирование | Средняя | Среднее |

| Массовая миграция между облаками | Низкая | Низкое |

Мне важно подчеркнуть: изменения будут быстрыми, но не одномоментными. Подготовиться можно уже сейчас. Автоматизируйте тесты. Думайте о приватности и переносимости. Это даст преимущество в ближайшие 1—2 года.

Долгосрочные перспективы и ключевые факторы успеха

Я смотрю на будущее и вижу несколько очевидных трендов. Модели станут более универсальными и мультимодальными. Обучение будет требовать ещё больше вычислительных ресурсов, но также станет эффективнее. Появятся новые аппаратные архитектуры и оптимизации. Большую роль сыграют стандарты и переносимость. Я бы выделил набор ключевых факторов, от которых будет зависеть успех компаний в долгой перспективе.

- Вычислительная мощность и оптимизация. Чем быстрее и дешевле считать, тем больше возможностей для новых сервисов.

- Доступ к качественным данным. Модели растут на данных. Их количество и разнообразие важны.

- Таланты и исследовательская культура. Лучшие команды придумывают прорывные идеи.

- Интеграция в экосистему продуктов. Решения, которые легко встроить, быстрее набирают аудиторию.

- Этика и регуляция. Компании, умеющие работать с регуляторами, будут иметь преимущество.

| Фактор | Почему важен |

|---|---|

| Инфраструктура | Обеспечивает масштаб и скорость вывода технологий в продукт |

| Партнёрства | Ускоряют доступ к рынкам и технологиям |

Для меня ключевой вопрос не кто сильнее сейчас, а кто сможет объединить ресурсы, таланты и правила игры вокруг себя.

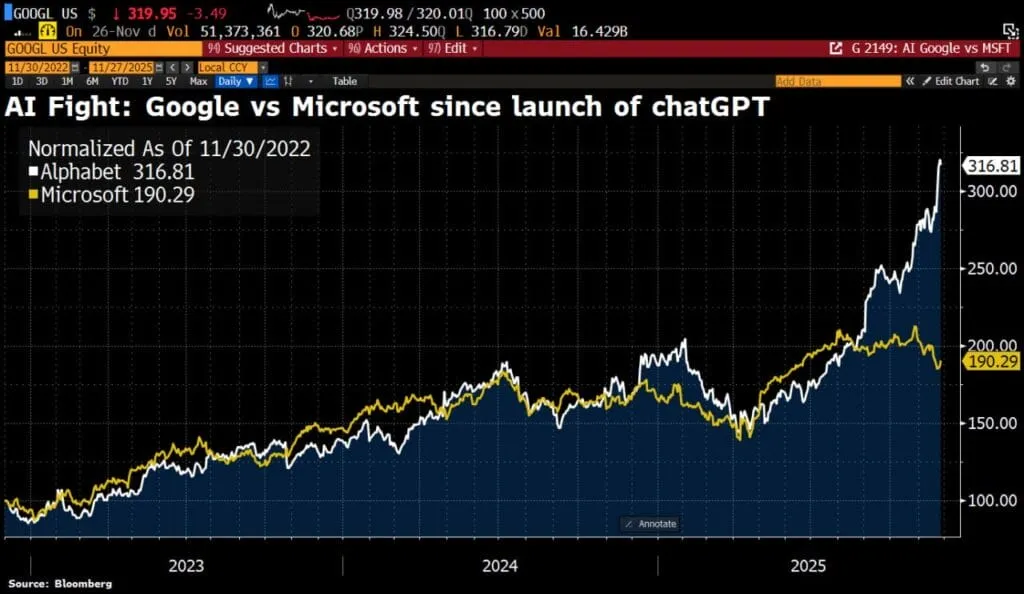

Вывод: кто выигрывает гонку и по каким критериям

Я понимаю, что ждать одного победителя бессмысленно. Победитель зависит от критериев. По исследованиям и публикациям чаще выигрывает Google. По облачным сервисам и корпоративным интеграциям сильнее Microsoft. По способности быстро встраивать ИИ в офисные и бизнес‑процессы Microsoft имеет явное преимущество. Google же лидирует в поиске, данных и экспериментах с моделями.

| Критерий | Преимущество |

|---|---|

| Исследования и модели | |

| Облачная платформа и интеграция для бизнеса | Microsoft |

| Потребительские продукты | Смешанный. Google сильна в поиске, Microsoft — в офисе |

| Партнёрства и монетизация | Microsoft |

- Если вам нужен академический прорыв или большие наборы данных, смотрите на Google.

- Если важна практическая интеграция в бизнес и устойчивые доходы, выбирайте Microsoft.

- Если нужен баланс между исследованием и приложением, решение зависит от конкретных потребностей.

В конце концов я считаю так: оба игрока выигрывают по‑своему.

Ваша задача — выбрать того, чей набор сильных сторон совпадает с вашими целями.